Tener correctamente configurado el archivo robots.txt, es una excelente manera de caer bien a Google y mejorar con ello el Posicionamiento SEO de nuestra web de una forma sencilla y eficaz.

El robots.txt funciona con los motores de búsqueda y de ahí la otra definición que también recibe “estándar para la exclusión de los robots”. Un nombre que revela cuál es su función, la cual detallaremos a continuación.

¿Qué es el archivo robots.txt?

Google en su buscador utiliza los conocidos como robots o arañas, los cuales son programas encargados de rastrear la web. Y una vez que llegan a tu página, su primer objetivo es encontrar el archivo robots.txt.

Este será el encargado de indicarle a dichas “Arañas” que robots son admitidos y qué páginas deben ser rastreadas o cuáles consideras que deben ser ignoradas.

¿Qué utilidades tiene el archivo robots.txt?

Como resumen, estas son algunas de las funciones principales que desempeña este interesante y útil archivo:

- Bloquear el acceso a los robots a cierta información que tienes en tu web que no quieres que los buscadores accedan (usuarios, contraseñas, contenido bloqueado por seguridad…)

- Impedir el acceso a los buscadores porque se están generando urls que duplican el contenido de tu página por ejemplo; se generan estas 3 urls: www.dominio.com/ejemplo/?iframe245 , www.dominio.com/ejemplo/?iframe247 y www.dominio.com/ejemplo/ y tienen exactamente el mismo contenido, con lo que si el robot accede va a entrar a todas esas urls y las va a indexar con el mismo contenido, y como ya sabréis google penaliza tanto el contenido duplicado interno como el externo, por lo que hay que indexar urls únicas con contenido único. Básicamente estamos facilitando el trabajo al buscador, porque estamos dejando solo las urls únicas que queremos que indexe. Sino el robot escogerá la que prefiera y te mostrará según sus criterios.

- Otra forma de evitar que google nos indexe estas urls que se han generado es poner canonical hacia la principal, pero de esto hablaré en próximas entradas. Muy importante es que siempre que bloquees cualquier url o elimines una url del índice de google aseguraros que no tiene visitas (podéis mirarlo por Google Analytics en páginas destino de posicionamiento natural)

- Al bloquear archivos es muy importante que no bloquees javascripts ni css… ya que sino googlebot no va a poder leer la página como realmente es.

- Indica la localización de los sitemap.xml

¿Cómo generar un archivo robots.txt?

Existen numerosas formas de generar este archivo, siendo algunas automáticas y otras manuales. Todo dependerá de las necesidades, la situación o incluso la plataforma.

Generar robots.txt manualmente

- Abril bloc de notas de windows

- Comando estándar para que el robot pueda acceder a todo tu sitio y no le bloquees nada:

User-agent: *

Disallow:

- Ahora es cuando vamos a poner las excepciones:

- Un comando que yo utilizo mucho es * y luego lo que quieras bloquear (que contenga esa palabra) , por ejemplo en el caso de arriba quiero bloquear todas las urls que se generen con iframe? Mi regla del robots sería

Disallow: *iframe?

- Otra forma de hacerlo es bloquear todas las urls que se generen con una interrogación:

Disallow: *?

En este comando hay que tener cuidado ya que puedes bloquear estilos.

- Una vez tengáis creado el archivo robots.txt lo debéis de guardar con el nombre robots.txt y en guardar como…: el formato en documentos de texto o .txt y subirlo a la carpeta raíz (/) por FTP.

- Y para indicárselo a google lo podéis enviar por webmaster tools el nuevo robots, y para cerciorarte de que no has bloqueado ningún estilo, puedes ir dentro de webmaster tools de google a la parte de explorar como google y le das a obtener y procesar toda la web, una vez esté explorada google te indicará si la tienes completada parcialmente o completa, si te sale completa le das a enviar ok, si te sale parcial, pincha encima de la frase de completada parcialmente y mira porque google no te está leyendo bien la página (si tienes alguna secuencia de comandos, estilos, css, imágenes) bloqueados te saldrá aquí en esta sección, en este caso si os encontráis que google no puede leer algo tenéis que permitir que acceda con el comando:

Allow: /theme/ ejemplo.css

Generar robots.txt con plugins

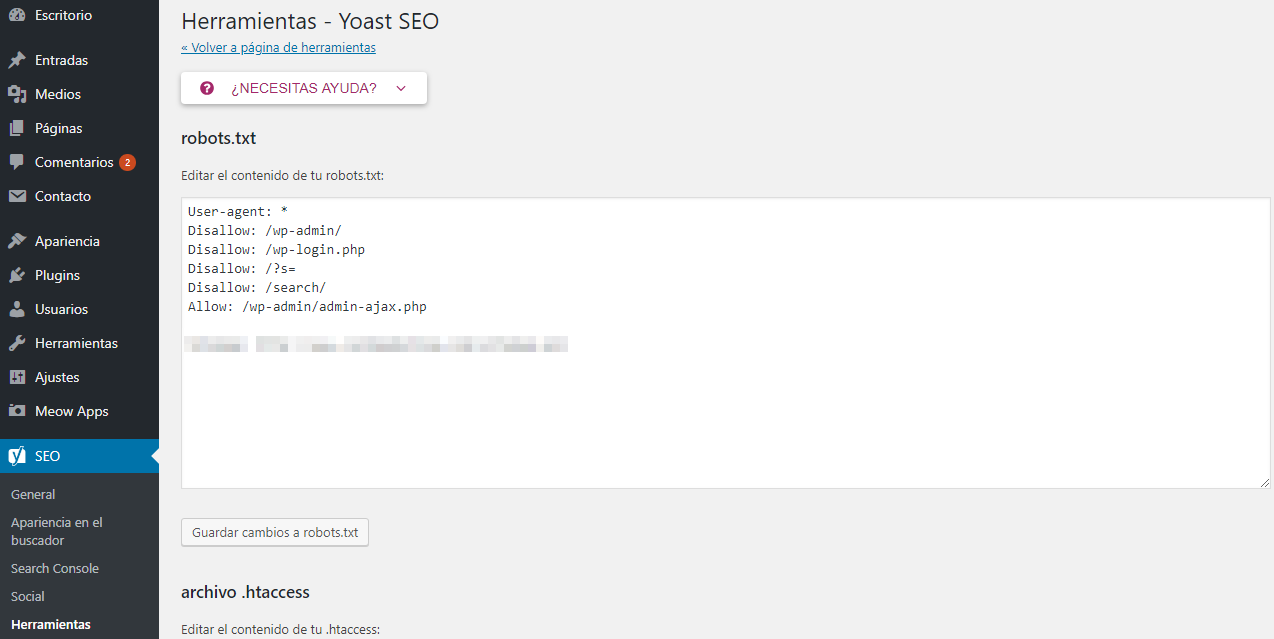

Otra opción interesante, especialmente si usas como CMS WordPress es el popular Yoast SEO, el cual en la sección Herramientas > Editor de Archivos tendrás un cómodo y sencillo editor donde podrás modificar lo que necesites.

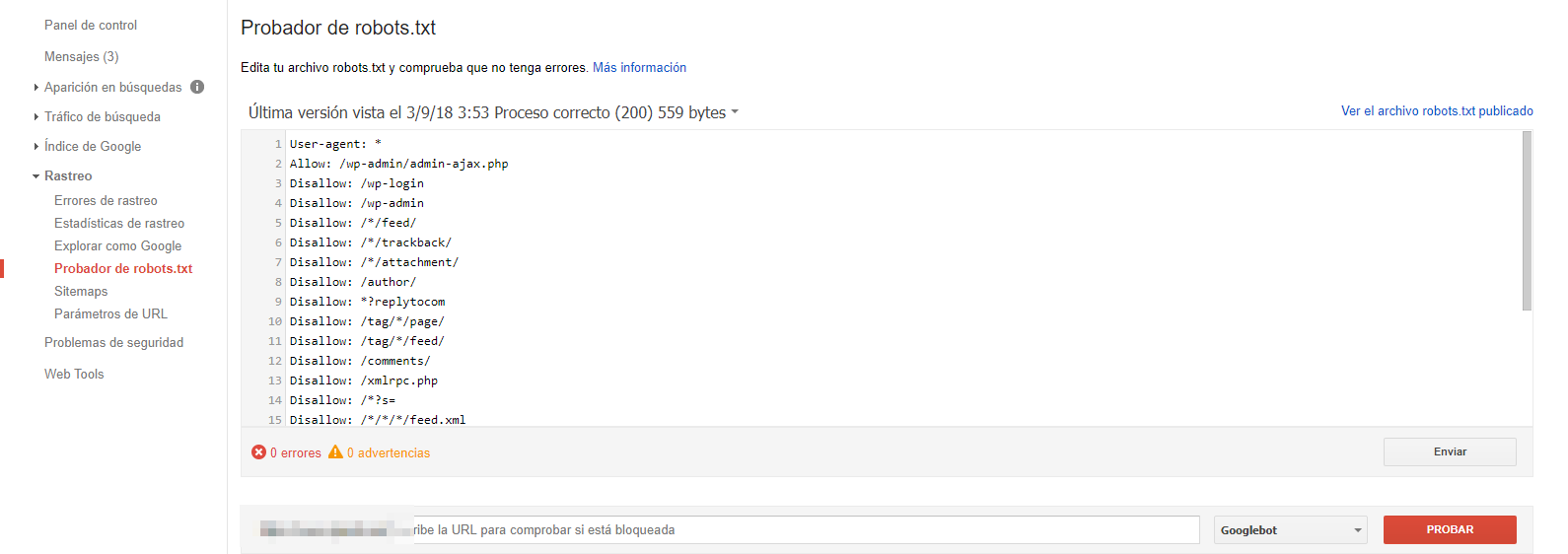

Probar y Enviar el robots.txt con Search Console

Probar y Enviar el robots.txt con Search Console

Si deseas comprobar que está correctamente configurado y que no estas bloqueando páginas importantes o simplemente quieres enviarlo a Google para que actualice el actual, Search Console es tu mayor aliada.

A continuación te dejamos una captura donde podrás ver el lugar al que tienes que acudir:

Esperamos que te resultara interesante nuestro nuevo artículo y que te sirva para mejorar el SEO de tu página web.

Unas sencillas acciones pueden conseguir que los buscadores gasten menos crawler en tu web y se centren únicamente en lo que es verdaderamente importante para ti.

Te invitamos a que nos sigas en tus redes sociales y a que compartas con tus contactos el artículo. Pronto nuevo contenido en el blog.